Dropout

Dropout

论文:

Srivastava, Nitish, et al. “Dropout: a simple way to prevent neural networks from overfitting.” Journal of Machine Learning Research 15.1 (2014): 1929-1958.

基本思想

目的:防止过拟合

方法:随机地移除一些神经单元

效果:有效地将很多个不同地网络架构结合起来

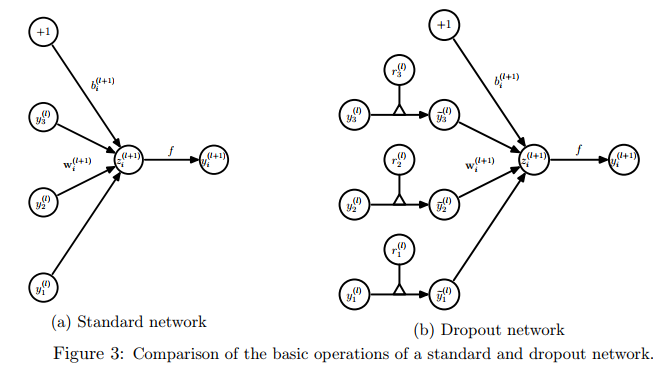

模型描述

前向传播:以概率p随机剔除神经单元

$$

r_j^l=Bernoulli(p),\ \

\hat{y}^l=r^l*y^l

$$

$$

z^{l+1}=w_i^{l+1}\hat{y}^l+b_i^{l+1},\ \

y^{l+1}=f(z_i^{l+1})

$$

反向传播:

对于每个batch的数据,每个参数的梯度为每个训练数据上取平均,其中没有用的那些参数梯度取0。

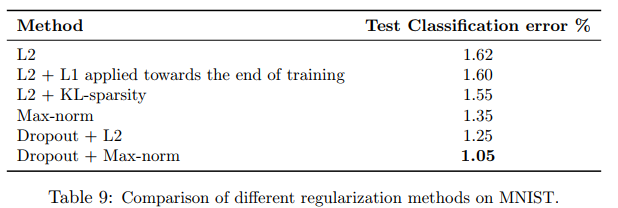

结合max-norm regularization效果更佳。

Experimental Results

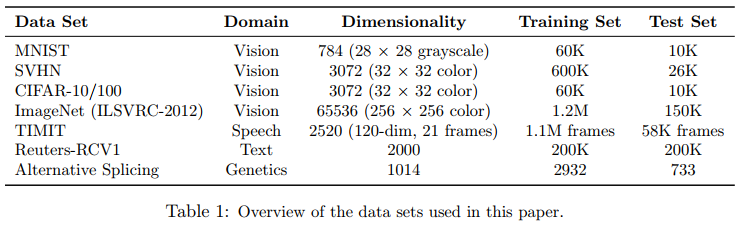

数据集:

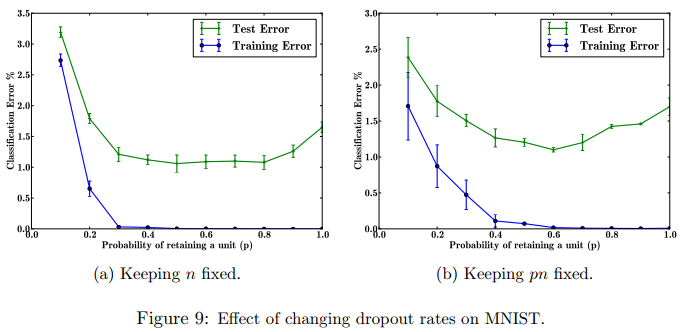

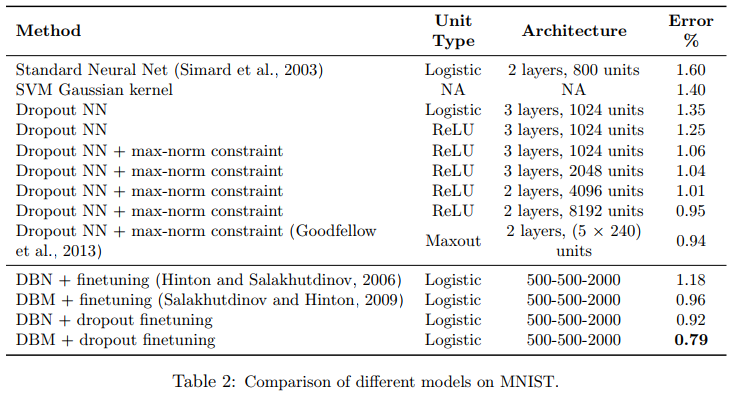

mnist上的结果

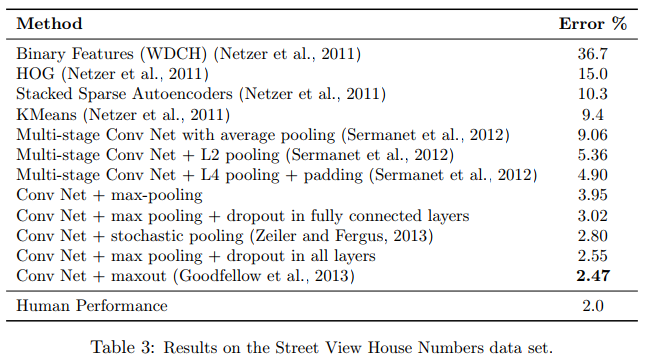

SVHN上的结果

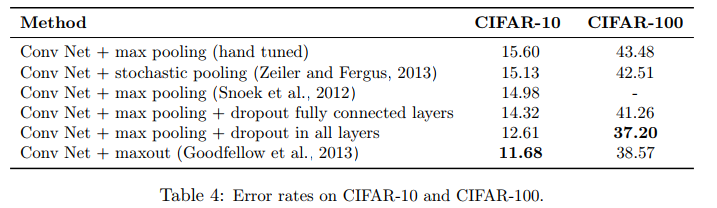

CIFAR上的结果

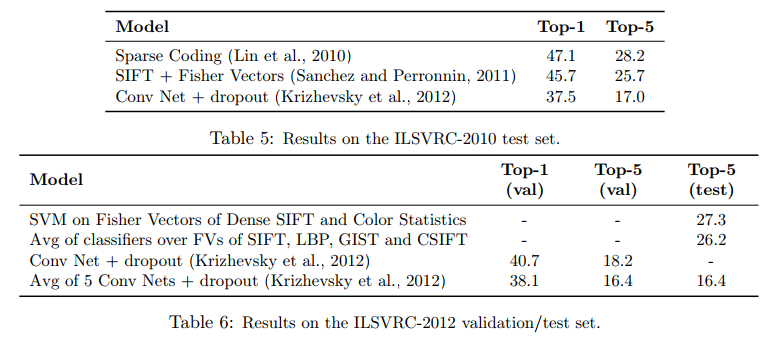

Imagenet上的结果

其他结果